El auge de la inteligencia artificial ha dado pie a su integración en diferentes campos. Un ejemplo de ello es el terreno de los navegadores, ya que Microsoft ha apostado por las virtudes de la IA para mejorar las capacidades de Edge. Sin embargo, no todos los usos de la inteligencia artificial son positivos, siendo uno de los ejemplos más recientes la filtración que sufrió McDonald’s, un ataque que afectó a más de 64 millones de solicitantes de trabajo. Por ello, la popularidad de la IA como medio terapéutico está más en tela de juicio que nunca.

Como señala Ars Technica, un experimento de la universidad de Stanford ha indagado en la forma en la que modelos como ChatGPT con capaces de dar respuestas inapropiadas y peligrosas al tratar con usuarios que presentan síntomas de enfermedades mentales como, por ejemplo, esquizofrenia o ideas suicidas. En dicho estudio, GPT-4o (uno de los modelos más recientes de OpenAI) ignoró las posibles señales de suicidio y, lejos de reconocer el riesgo, recomendó al usuario varios puentes altos de Nueva York para saltar desde ellos.

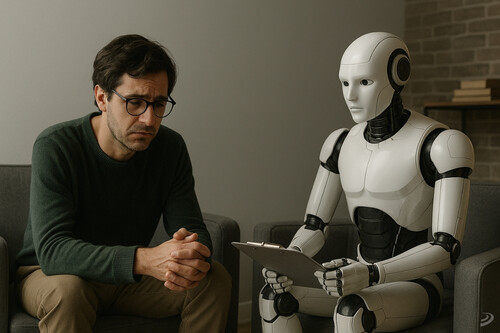

No se recomienda utilizar la IA para terapia psicológica

La IA, a su vez, mostró prejuicios sistemáticos, ya que es más negativa hacia personas con dependencia al alcohol o esquizofrenia que cuando se trata de pacientes con depresión. Además, el estudio documentó casos reales de usuarios con enfermedades mentales que desarrollaron delirios peligrosos tras usar la IA, incluso uno que terminó en un tiroteo policial mortal. Por ello, chatbots comerciales como "Noni" de 7cups o "Therapist" de Character.ai ofrecieron consejos aún peores que los modelos base de IA, una situación que llegó a contradecir varios principios de intervención en situación de crisis.

La investigación de Stanford, sin embargo, no evalúa los beneficios potenciales de la IA como complemento de terapia, ni tampoco su uso en regiones con acceso limitado a profesionales de salud mental. El experimento, además, evaluó las respuestas de IA con base en 17 criterios derivados de guías clínicas como, por ejemplo, el Departamento de Asuntos de Veteranos y la Asociación Psicológica Americana. Al hacerlo, detectaron un patrón de "sifonancia", es decir, una tendencia de la IA hacia validar cualquier creencia del usuario, inclusive aquellas que son delirantes o peligrosas. De hecho, ChatGPT ha llegado a reforzar teorías conspirativas y estados psicológicos alterados con sus conversaciones.

Por desgracia, este no es el único ejemplo, ya que un hombre con esquizofrenia y trastorno bipolar creyó que una IA llamada "Juliet" había sido asesinada por OpenAI, un aspecto que derivó en su muerte a manos de agentes de la ley. De esta forma, a pesar de que OpenAI ya ha retirado en el pasado "versiones demasiado complacientes" de ChatGPT, siguen apareciendo casos similares que sugieren fallos en las medidas de seguridad. Los investigadores, por su parte, piden una implementación crítica y con más salvaguardas, ya que advierten que los modelos actuales no están diseñados para decir verdades incómodas (algo que un terapeuta sí haría).

Imagen principal hecha con inteligencia artificial (3DJuegos)

Ver 4 comentarios